De acuerdo con . . .

https://www.symantec.com/blogs/feature-stories/top-20-shady-top-level-domains

...

Informe sobre los TLD (Top-Level Domains) más sospechosos que existen hoy en día.

...

No parece haber muchos sitios legítimos -- útiles en los siguientes dominios . . . a menos que le guste el peligro .. XD ..

De acuerdo con . . .

https://www.spamhaus.org/statistics/tlds/

. . .

Spam ..:: Correo basura y mensaje basura. Incluyen grupos de noticias, usenet, motores de búsqueda, redes sociales, páginas web, wiki, foros, blogs, a través de ventanas emergentes y todo tipo de imágenes y textos en la web.

https://es.wikipedia.org/wiki/Spam

. . .

Lo peor de lo peor . . . .

The World's Most Abused TLDs

The World's Worst Spam Enabling Countries

. . .

De acuerdo con . . .

https://promos.mcafee.com/en-US/PDF/MTMW_Report.pdf

.. .. .. De los mas completos y profesionales .

Track sites containing malicious or potentially dangerous content and activities including:

•

Malware—Code that can damage a system, steal data, or perform malicious activities on another computer (includes keyloggers, password stealers, and zombie kits).

•

Browser exploits—Attacks and malware that take advantage of vulnerable software.

•

Phishing—Fake sites that appear to be legitimate but are designed to “phish” for information or install malicious code.

•

Spamminess—Sign-up forms that will cause the person to receive large amounts of commercial email, or spam.

•

Risky affiliations—Sites with links that take the user to a malicious site, and sites that have suspicious associations, such as their site ownership, registration, or hosting service.

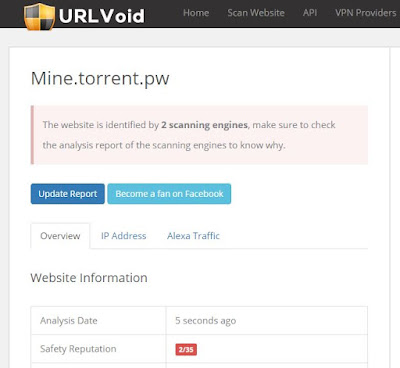

En la imagen inferior . . . Lo mejor de lo peor al comienzo de la lista . . .

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

Una forma sencilla de protegerse mediante Privoxy . . . (una lista mas inflada por precaucion XD )

Seria añadiendo a su action-file +block ..::

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

## ## ## ## ## ## ## ## ## ## ## ##

# -------------------------------------------------------------------------------------

{+block{MisBloqueos-Dominios}}

# -------------------------------------------------------------------------------------

.accountant/

.accountants/

.am/

.asia/

.bid/

.biz/

.cc/

.cf/

.christmas/

.click/

.cm/

.country/

.cricket/

.date/

.download/

.faith/

.fun/

.ga/

.gb/

.gdn/

.ge/

.gq/

.info/

.jetz/

.kim/

.kz/

.link/

.loan/

.me/

.men/

.ml/

.mobi/

.mom/

.ms/

.name/

.ninja/

.nu/

.online/

.party/

.ph/

.pk/

.pro/

.racing/

.realtor/

.ren/

.review/

.ro/

.science/

.space/

.st/

.stream/

.study/

.su/

.tc/

.tech/

.tk/

.to/

.top/

.trade/

.tt/

.tv/

.vip/

.vn/

.wang/

.win/

.work/

.ws/

.xin/

.xyz/

.yokohama/

.zip/

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

Con la creciente libertad en TLDs genericos la lista se volvera inmensa . . .

Bloquear por medio Dominios de nivel superior (TLDs)

- cTLDs; de pais como: .mx, .jp, .us . . .

- ngTLDs; nueva identidad en pais como: .tokyo, .london, .nyc . . .

- gTLDs; genericos como: .info, .top, .club, .vip . . .

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

Algo mas osado en Privoxy; Con ayuda de PowerShell W10 . ..::

- Bloquear todos los dominios execto los comunes y mas limpios (por decirlo de algun modo XD )

- Most popular web domains worldwide: .com .org .net .us .co .de .uk .ru .jp .cn .fr .it .br

- Cada uno debe determinar sus "Dominios a mantener abiertos": br/, co/, com/, es/, mx/, net/, org/, tv/, uk/ .. . . .... como ejemplo note abajo la propuesta para ser utilizada en Privoxy ..::

## ## ## ## ## ## ## ## ## ## ## ##

# -------------------------------------------------------------------------------------

{+block{MisBloqueos-Dominios}}

# -------------------------------------------------------------------------------------

# Dominios - No .com/ .mx/ .net/

# -------------------------------------------------------------------------------------

# .*/ # cerrar todos los dominios.

# ----------- Dominios inusuales bloqueados

#.[0-9]*/

#.*[0-9]/

#.*[0-9]*/

?.?/

?.*/

*/

# most popular web domains worldwide, Most Common Domain Extensions

# .com .org .net .us .co .de .uk .ru .jp .cn .fr .it .br

# - Dominios abiertos: br/, co/, com/, es/, mx/, net/, org/, tv/, uk/

# cerrando los otros dominios ..: a[b][c]d[e]fghijkl[m][n][o]pqrs[t][u]vwxyz

.[adf-lp-sv-z]*/

# eludiendo .br/ . . . .

.b[a-qs-z]/

.b[a-z][a-z]*/

# eludiendo .co/ . . . .

.c[a-np-z]/

# eludiendo .com/ . . . .

.c[a-np-z][a-ln-z]/

.co[a-ln-z]/

.c[a-np-z]m/

.c[a-z][a-z][a-z]*/

# eludiendo españa .es/ . . . .

.e[a-rt-z]/

.e[a-z][a-z]*/

# eludiendo mexico .mx/ . . . .

.m[a-wy-z]/

.m[a-z][a-z]*/

# eludiendo .net/ . . . .

.n?/

.n[a-df-z][a-su-z]/

.ne[a-su-z]/

.n[a-df-z]t/

.n[a-z][a-z][a-z]*/

# eludiendo .org/ . . . .

.o?/

.o[a-qs-z][a-fh-z]/

.or[a-fh-z]/

.o[a-qs-z]g/

.o[a-z][a-z][a-z]*/

# eludiendo .uk/ . . . .

.u[a-jl-z]/

.u[a-z][a-z]*/

# eludiendo .tv/ . . . .

.t[a-uw-z]/

.t[a-z][a-z]*/

#--------------------------------------------

Notese que con Dominios abiertos: br/, co/, com/, es/, mx/, net/, org/, tv/, uk/ .. me refiero a que no los estoy afectando por lo que no se bloquean . . :D . . .Muy efectivo no importa que tipo o nuevos dominios surjan solo pueden cruzar los que yo permito. . . ;D

- Eliminar esos dominios de mi filehosts action-file +Block debido aque esas urls en si ya no pasaran. logrando aligerar el archivo.

Del sitio ... https://github.com/StevenBlack/hosts

copiar y nombrar ... ... ... StevenBlackhosts-original.txt

----------------------------------------------------------------

Dejando las puras urls Steven Black

----------------------------------------------------------------

# reemplazando 0.0.0.0 por nada

# eliminando lineas con # y vacias

# borrando hasta la 9 linea

Get-Content "StevenBlackhosts-original.txt" | Select-Object -Skip 30 | Foreach-Object {$_ -Replace('^0.0.0.0 ', '')} | Where-Object {$_ -notmatch '#'} | ? {$_.trim() -ne "" } | Set-Content "StevenBlackhosts-urls.txt"

----------------------------------------------------------------

Elimando la carga extra de urls en Steven Black Hosts

----------------------------------------------------------------

Get-Content "StevenBlackhosts-urls.txt" | Foreach-Object {$_ -Replace('^.+:\d*:','')} |

Where-Object {$_ -notmatch '\.[adf-lp-sv-z]\w*$'} |

Where-Object {$_ -notmatch '\.b[a-qs-z]$'} |

Where-Object {$_ -notmatch '\.b[a-z][a-z]\w*$'} |

Where-Object {$_ -notmatch '\.c[a-np-z]$'} |

Where-Object {$_ -notmatch '\.c[a-np-z][a-ln-z]$'} |

Where-Object {$_ -notmatch '\.co[a-ln-z]$'} |

Where-Object {$_ -notmatch '\.c[a-np-z]m$'} |

Where-Object {$_ -notmatch '\.c[a-z][a-z][a-z]\w*$'} |

Where-Object {$_ -notmatch '\.e[a-rt-z]$'} |

Where-Object {$_ -notmatch '\.e[a-z][a-z]\w*$'} |

Where-Object {$_ -notmatch '\.m[a-wy-z]$'} |

Where-Object {$_ -notmatch '\.m[a-z][a-z]\w*$'} |

Where-Object {$_ -notmatch '\.n.$'} |

Where-Object {$_ -notmatch '\.n[a-df-z][a-su-z]$'} |

Where-Object {$_ -notmatch '\.ne[a-su-z]$'} |

Where-Object {$_ -notmatch '\.n[a-df-z]t$'} |

Where-Object {$_ -notmatch '\.n[a-z][a-z][a-z]\w*$'} |

Where-Object {$_ -notmatch '\.o.$'} |

Where-Object {$_ -notmatch '\.o[a-qs-z][a-fh-z]$'} |

Where-Object {$_ -notmatch '\.or[a-fh-z]$'} |

Where-Object {$_ -notmatch '\.o[a-qs-z]g$'} |

Where-Object {$_ -notmatch '\.o[a-z][a-z][a-z]\w*$'} |

Where-Object {$_ -notmatch '\.u[a-jl-z]$'} |

Where-Object {$_ -notmatch '\.u[a-z][a-z]\w*$'} |

Where-Object {$_ -notmatch '\.t[a-uw-z]$'} |

Where-Object {$_ -notmatch '\.t[a-z][a-z]\w*$'} |

Where-Object {$_ -notmatch '^.\.\w*$'} |

Where-Object {$_ -notmatch '^cfvod\.kaltura\.com$'} |

Where-Object {$_ -notmatch '^cdnapi\.kaltura\.com$'} |

Where-Object {$_ -notmatch '^jwpltx\.com$'} |

Sort-Object -Unique | Set-Content "StevenBlackhosts-urls-clean.txt"

----------------------------------------------------------------

Notese

-- Al final elimino algunos sitios del Hosts-File; sitios para mi frecuentes pero revisados en VirusTotal .. XD

-- Claro Dominios abiertos: br/, co/, com/, es/, mx/, net/, org/, tv/, uk/ ... son mis frecuentes usted añada los suyos . . . por lo que tendra que modificar . . XD .. pero el ejemplo esta expuesto .. XD

-- Claro si usa WildCards en Privoxy al elimar las urls ya afectadas el peso final del archivo sera una pluma comparado al original . . .Feliz Caceria . . ;D

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

Mas informacion de por que no arriesgarse . . XD

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

Referencias:

# - https://www.symantec.com/blogs/feature-stories/top-20-shady-top-level-domains

# - https://promos.mcafee.com/en-US/PDF/MTMW_Report.pdf

# - https://www.spamhaus.org/statistics/tlds/

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -